Sommaire

Définition du SEO technique

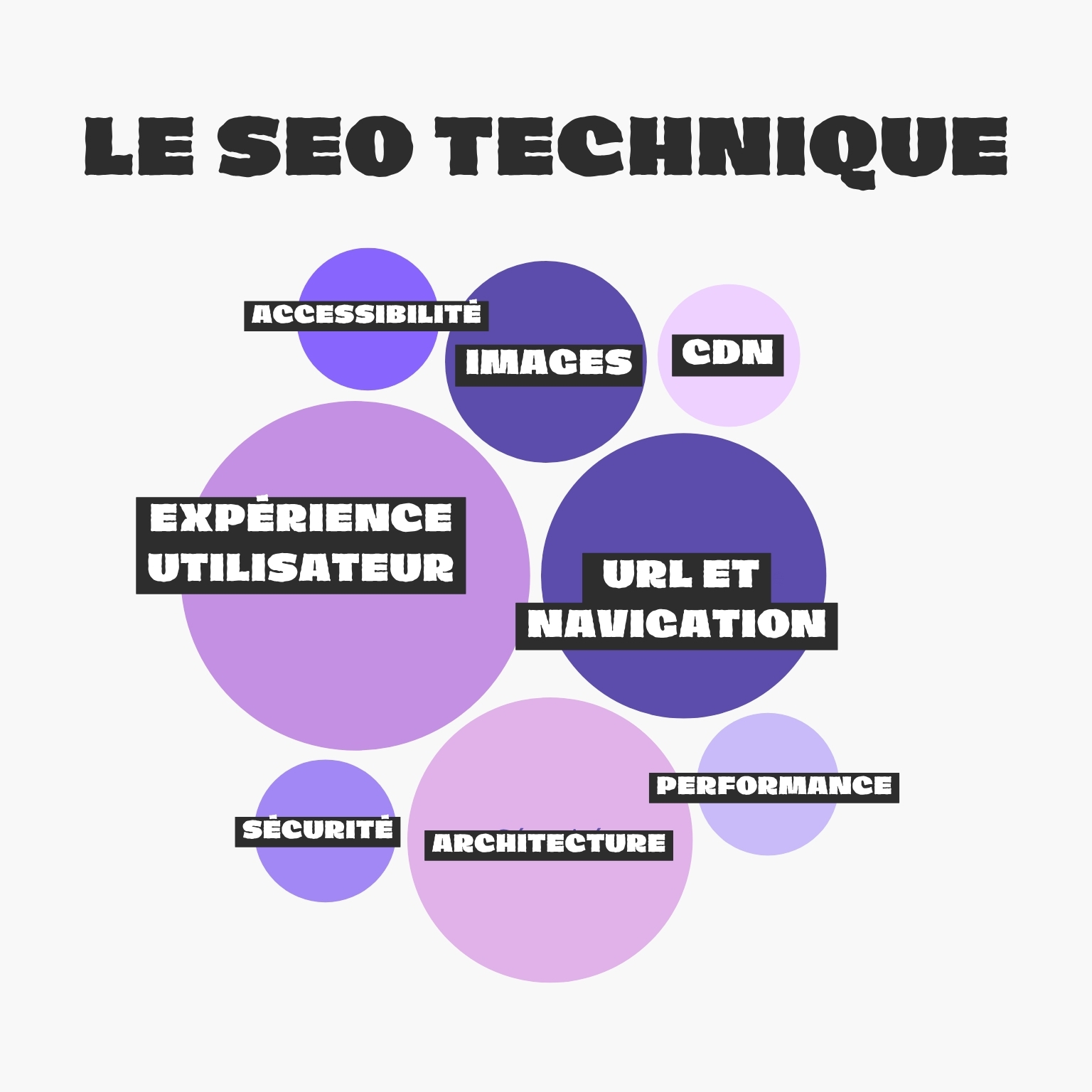

Le SEO technique désigne l’ensemble des optimisations qui facilitent l’exploration, l’indexation et l’interprétation de ton site par les moteurs de recherche. Contrairement au SEO on-page (contenu, mots-clés, UX) et au SEO off-page (backlinks, notoriété), il s’agit ici de la partie invisible mais essentielle du référencement : structure du site, vitesse, code, sécurité, mobile… C’est le socle technique sur lequel repose toute ta visibilité organique.

Pourquoi le SEO technique est un pilier du référencement ?

Le SEO technique est le pilier qui soutient les deux autres. Sans une architecture claire, un temps de chargement rapide et une bonne indexabilité, même le meilleur contenu restera invisible. Il permet aux robots de Google d’accéder à tes pages, de comprendre leur structure, et de les positionner correctement. Un site techniquement optimisé assure aussi une bonne expérience utilisateur — critère de plus en plus valorisé par les algorithmes.

1️⃣ Accessibilité pour les robots d’indexation

Robots.txt : que faut-il bloquer ?

Le fichier robots.txt est un petit fichier texte situé à la racine de ton site. Il sert à donner des instructions aux robots d’indexation (comme Googlebot) sur ce qu’ils peuvent ou ne peuvent pas explorer.

Ce qu’il faut bloquer :

- Les dossiers techniques inutiles (ex : /wp-admin/, /cgi-bin/)

- Les pages de résultats internes ou les filtres (ex : /search/)

- Les doublons ou versions non-canoniques d’une même page

À éviter :

- Ne jamais bloquer une page que tu souhaites indexer.

- Ne pas bloquer accidentellement des ressources essentielles (CSS, JS).

Fichier sitemap.xml : comment le structurer efficacement

Le sitemap XML est un fichier qui liste toutes les URLs importantes de ton site à faire découvrir aux moteurs. Il aide à améliorer la couverture d’indexation.

Conseils :

- Inclure uniquement les pages utiles (indexables, à jour, non bloquées).

- Organiser par type de contenu si le site est vaste (ex : articles, fiches produits).

- Mettre à jour automatiquement avec les nouveaux contenus.

- Déclarer le fichier dans la Google Search Console.

Balises meta robots (index, noindex, follow, etc.)

Chaque page peut porter une balise <meta name= »robots »> dans son en-tête HTML. Elle guide l’indexation :

- index, follow (par défaut) : page indexée et liens suivis.

- noindex, follow : la page n’est pas indexée mais ses liens sont suivis.

- noindex, nofollow : la page et ses liens sont ignorés.

- noarchive : empêche Google de stocker une version en cache.

À utiliser stratégiquement pour éviter d’indexer des pages inutiles, comme les pages panier, les filtres ou les zones privées.

2️⃣ Architecture du site et arborescence

Structure en silo vs structure plate

Une bonne architecture aide Google à comprendre la hiérarchie de ton contenu. Deux structures principales existent :

- Structure plate : toutes les pages sont accessibles en 1 ou 2 clics. Simple à explorer, mais peu hiérarchisée.

- Structure en silo : les contenus sont organisés par thématiques, avec des catégories et sous-catégories bien définies. C’est idéal pour renforcer la pertinence sémantique d’un groupe de pages.

💡 Astuce

Pense à aligner ta structure avec les intentions de recherche (informationnelle, commerciale, navigationnelle).

Maillage interne intelligent

Le maillage interne consiste à créer des liens entre les pages de ton propre site. Il permet de :

- Transmettre de l’autorité d’une page à une autre (link juice interne)

- Guider les robots vers les pages profondes

- Améliorer la navigation pour les utilisateurs

Utilise des ancres de lien pertinentes et varie-les. N’oublie pas de lier depuis tes pages à fort trafic ou autorité vers les pages à booster.

Profondeur de page et crawl budget

Plus une page est enfouie dans la structure (à 4 clics ou plus), moins elle a de chances d’être explorée régulièrement par Google. On parle de profondeur de page.

Le crawl budget, quant à lui, représente le nombre de pages que Google est prêt à explorer sur ton site lors de chaque visite. Si tu gaspilles ce budget avec des pages peu utiles (tags, filtres, contenus obsolètes), tu risques de ralentir l’indexation de pages importantes.

💡 Objectif

Aucune page stratégique ne doit dépasser 3 clics depuis la page d’accueil.

3️⃣ Performance technique et vitesse

Core Web Vitals : LCP, FID, CLS

Les Core Web Vitals sont des indicateurs de performance définis par Google pour évaluer l’expérience utilisateur. Depuis mai 2021, ils sont officiellement intégrés aux signaux de classement.

- LCP (Largest Contentful Paint) : mesure le temps nécessaire à l’affichage de l’élément principal d’une page. Objectif : moins de 2,5 secondes.

- FID (First Input Delay) : mesure le délai entre une action de l’utilisateur (clic, scroll) et la réaction du site. Objectif : moins de 100 ms.

- CLS (Cumulative Layout Shift) : évalue la stabilité visuelle d’une page (éviter les décalages de mise en page). Objectif : score inférieur à 0,1.

Ces indicateurs sont disponibles dans PageSpeed Insights, la Search Console et Lighthouse.

Optimisation du temps de chargement

La vitesse de chargement est cruciale à la fois pour le SEO et pour la rétention utilisateur. Un site lent fait fuir les visiteurs et pénalise ton classement.

Voici quelques optimisations clés :

- Réduction du TTFB (Time To First Byte) via un bon hébergeur

- Lazy loading des images et vidéos (chargement différé)

- Minification des fichiers CSS, JS, HTML

- Compression GZIP ou Brotli pour alléger les ressources

- Mise en cache efficace des pages et fichiers statiques

- Images WebP ou SVG pour un meilleur ratio qualité/poids

Astuce : teste tes pages avec GTmetrix, WebPageTest ou PageSpeed Insights pour identifier les goulots d’étranglement.

CDN et hébergement optimisé

Un CDN (Content Delivery Network) permet de stocker ton contenu sur plusieurs serveurs répartis dans le monde. Résultat : une page se charge plus vite, peu importe l’emplacement du visiteur.

- Réduction du temps de chargement

- Amélioration de la disponibilité en cas de pic de trafic

- Meilleure sécurité grâce aux protections DDoS

Choisis aussi un hébergeur performant, comme Hostinger capable de gérer le volume de trafic et les optimisations serveur. Les hébergements mutualisés trop limités sont à éviter pour des projets SEO sérieux.

4️⃣ Mobile et responsive design

Index mobile-first : implications concrètes

Depuis 2019, Google utilise l’indexation mobile-first par défaut. Cela signifie qu’il se base sur la version mobile de ton site pour déterminer son classement. Si la version mobile est incomplète, lente ou mal optimisée, cela affectera directement ta visibilité SEO.

Implications :

- Ton site doit être responsive, pas seulement adapté.

- Le contenu affiché en version mobile doit être identique ou équivalent à celui en desktop.

- Les balises, les liens internes, les données structurées doivent également être présentes.

Ne pense plus “mobile comme option”, mais “mobile comme référence”.

Tests mobile-friendly

Google propose un outil gratuit pour tester si ton site est adapté au mobile :

🔗 Test d’optimisation mobile de Google

Ce test analyse :

- La lisibilité du texte sans zoom

- L’adaptation des éléments cliquables

- L’affichage correct sans défilement horizontal

- L’absence d’erreurs de chargement spécifiques aux appareils mobiles

Un site bien noté sur ce test est mieux positionné dans les résultats mobiles (qui représentent la majorité du trafic aujourd’hui).

Responsive UX : navigation et contenu adaptés

Le responsive ne se limite pas à redimensionner les éléments. Il faut penser expérience utilisateur mobile :

- Menus hamburger intuitifs

- Boutons facilement cliquables avec le pouce

- Police suffisamment lisible sur petits écrans

- Éviter les pop-ups intrusifs (interstitiels bloquants pénalisés par Google)

Un site mobile agréable à naviguer est un site qui retient les visiteurs et améliore les signaux comportementaux (dwell time, taux de rebond, conversion).

Passons à la prochaine section du guide SEO technique : la sécurité et la confiance. Ces éléments sont fondamentaux pour inspirer la fiabilité aux yeux de Google et de tes visiteurs.

5️⃣ Sécurité et confiance

HTTPS obligatoire

Depuis 2018, Google considère le protocole HTTPS comme un critère de classement. Tout site web non sécurisé (HTTP) est marqué comme “non sécurisé” dans Chrome, ce qui nuit à la fois au SEO et à l’expérience utilisateur.

Migrer vers HTTPS est donc indispensable :

- Chiffrement des données entre le navigateur et le serveur

- Protection contre les interceptions ou injections malveillantes

- Gage de sérieux pour les utilisateurs

💡 L’activation d’un certificat SSL est aujourd’hui possible gratuitement via Let’s Encrypt chez la plupart des hébergeurs.

Certificats SSL et redirections sécurisées

Un certificat SSL (Secure Socket Layer) valide assure que ton HTTPS est fonctionnel. Vérifie que :

- Il est bien activé et à jour

- Toutes les versions HTTP de ton site redirigent vers la version HTTPS via des redirections 301

- Il n’existe aucune version mixte (contenu HTTP dans des pages HTTPS), ce qui provoquerait des alertes de sécurité

➡️ Utilise des outils comme Why No Padlock pour identifier les contenus non sécurisés.

Pages d’erreur personnalisées (404, 500…)

Les pages d’erreur sont inévitables, mais elles peuvent nuire à l’expérience utilisateur si elles ne sont pas traitées correctement.

Recommandations :

- Créer une page 404 personnalisée : claire, utile, avec un lien vers la page d’accueil ou un moteur de recherche interne

- Suivre régulièrement les erreurs 404 dans Google Search Console

- Corriger ou rediriger les erreurs 404 fréquentes (vers une page pertinente, jamais la home)

Les erreurs 5xx (erreurs serveur) sont plus graves : elles indiquent un dysfonctionnement de l’hébergement. Une répétition de ces erreurs peut gravement nuire à l’indexation et à la réputation technique du site.

6️⃣ Structuration du code

Balises HTML essentielles (Hn, Title, Meta)

Les balises HTML structurent ton contenu pour les moteurs de recherche. Une bonne hiérarchie permet à Google de comprendre la logique de ta page.

- Balise <title> : elle apparaît dans les résultats Google. Elle doit contenir le mot-clé principal, être unique et ne pas dépasser 65-70 caractères.

- Balise <meta description> : bien qu’elle n’impacte pas directement le ranking, elle influence le taux de clic (CTR). Rédige un texte engageant de 150-160 caractères.

- Balises H1 à H6 : le H1 est réservé au titre principal (1 seul par page). Les H2, H3, etc. structurent les sous-parties. Évite d’en sauter une hiérarchie (pas de H3 sans H2).

Objectif : un balisage clair, logique et cohérent pour Google comme pour l’utilisateur.

Microdonnées et balisage Schema.org

Le balisage sémantique permet de structurer des données pour que Google puisse les afficher sous forme de rich snippets (extraits enrichis) dans les SERP.

Exemples :

- Avis utilisateurs : ⭐⭐⭐⭐⭐

- Recettes : ⏱ Temps, calories, étapes

- Produits : prix, disponibilité, marque

- Événements : date, lieu, organisateur

Utilise le vocabulaire de Schema.org avec le format JSON-LD recommandé par Google. Tu peux générer ces balises avec des outils comme Google Structured Data Markup Helper ou Schema Markup Generator de Merkle.

Canonical et gestion des pages dupliquées

Les pages dupliquées peuvent nuire au SEO, car elles diluent le jus SEO et peuvent entraîner une désindexation.

Solutions :

- Utiliser la balise <link rel= »canonical »> pour indiquer à Google la version principale d’une page.

- Éviter les contenus répliqués via des URL de filtres, de tri ou de pagination.

- Rediriger proprement les doublons ou variantes d’URL (ex : www vs non-www, http vs https).

- Utiliser des outils comme Screaming Frog ou Siteliner pour repérer les duplications internes.

💡 Conseil : ne canonise jamais toutes tes pages vers la home — ça crée plus de confusion qu’autre chose.

7️⃣ Indexabilité et erreurs courantes

Pages orphelines

Une page orpheline est une page qui n’est liée à aucune autre page du site. Cela signifie que ni les visiteurs ni les robots d’indexation ne peuvent y accéder facilement.

Pourquoi c’est problématique ?

- Elle consomme inutilement ton crawl budget

- Elle n’a aucun lien interne entrant, donc aucun jus SEO transmis

- Elle est souvent mal indexée, voire ignorée

➡️ Solution : identifier les pages orphelines via des outils comme Screaming Frog ou Ahrefs, puis intégrer des liens internes logiques vers ces pages depuis des articles connexes ou des catégories.

Erreurs 4xx et 5xx à surveiller

Les erreurs de type 4xx (client) et 5xx (serveur) indiquent à Google des problèmes d’accès aux pages de ton site.

- 404 : Page non trouvée → soit rediriger, soit désindexer si la page n’a plus d’utilité.

- 403 : Accès refusé → attention aux restrictions serveur ou aux règles de sécurité mal configurées.

- 500 : Erreur serveur → problème d’hébergement ou de script qui empêche la page de se charger.

🔎 Où les détecter : Google Search Console > Couverture > Pages avec erreurs.

Objectif : corriger rapidement les erreurs fréquentes ou critiques, car elles affectent négativement le crawl et la réputation technique du site.

Indexation inutile et contenu maigre

Google indexe (ou tente d’indexer) tout ce qu’il trouve, y compris des pages à faible valeur ajoutée, dupliquées ou inutiles.

Exemples de contenu à limiter :

- Pages d’auteur sans contenu

- Fiches produit avec description identique

- Résultats de recherche interne

- Pages de tags ou d’archives vides

Ces pages créent du bruit SEO. Trop de contenu “mince” ou inutile peut faire baisser la qualité perçue de l’ensemble du site.

➡️ Solutions :

- Mettre les pages faibles en noindex

- Fusionner ou enrichir les contenus similaires

- Bloquer certaines sections dans robots.txt ou via meta robots

Outils indispensables du SEO technique

Google Search Console

Gratuit et fourni par Google, cet outil est un incontournable absolu. Il te permet de :

- Suivre l’indexation de tes pages

- Identifier les erreurs techniques (404, pages bloquées, problèmes mobile…)

- Inspecter le fichier sitemap

- Mesurer les performances (Core Web Vitals)

- Gérer le désaveu de liens toxiques

- Recevoir des alertes SEO critiques

➡️ C’est ta première source d’information pour comprendre comment Google “voit” ton site.

Screaming Frog, Ahrefs, Semrush

Ces outils sont plus avancés et payants, mais ils offrent des fonctionnalités très puissantes :

- Screaming Frog SEO Spider : outil de crawl local de site. Il simule le comportement de Googlebot, détecte les erreurs de balisage, les pages orphelines, les canoniques mal définies, etc.

- Ahrefs & Semrush : en plus du netlinking, ces plateformes proposent des audits techniques complets : performance, duplicate content, SEO mobile, crawlability, etc.

- Jet Octopus, Oncrawl, Sitebulb : d’autres alternatives puissantes selon ton niveau d’expertise.

PageSpeed Insights, GTmetrix, WebPageTest

Ces outils analysent la vitesse de chargement et les Core Web Vitals.

- PageSpeed Insights (Google) : note mobile et desktop, recommandations de performance.

- GTmetrix : plus visuel, avec TTFB, waterfall, et suggestions concrètes.

- WebPageTest : très détaillé, idéal pour tests par localisation, appareil ou connexion.

💡 Combine ces outils pour croiser les données et identifier les véritables leviers d’optimisation.

Checklist SEO technique à suivre en 2025

Vérifications mensuelles

🔲 Suivi des erreurs dans Google Search Console (pages bloquées, erreurs 404, balises manquantes)

🔲 Surveillance des performances via PageSpeed Insights et Core Web Vitals

🔲 Contrôle des nouvelles pages orphelines ou non indexées

🔲 Vérification des redirections et canonicals

🔲 Test mobile-friendly sur quelques pages clés

🔲 Analyse des logs serveur (fréquence de crawl, erreurs récurrentes)

Vérifications trimestrielles

🔲 Audit complet du site avec Screaming Frog ou Semrush

🔲 Mise à jour et optimisation du fichier sitemap.xml

🔲 Contrôle du robots.txt et des balises meta robots

🔲 Vérification des balises hreflang si site multilingue

🔲 Suivi du crawl budget et des pages en profondeur excessive (> 3 clics)

Vérifications annuelles

🔲 Renouvellement du certificat SSL

🔲 Audit de sécurité (plugins, CMS, certificats, injections)

🔲 Vérification des pages à faible contenu ou non performantes

🔲 Suppression ou redirection des pages obsolètes

🔲 Revue globale de l’architecture et du maillage interne

Priorisation des tâches selon leur impact SEO

✅ Haute priorité : erreurs d’indexation, pages critiques non accessibles, Core Web Vitals

✅ Priorité moyenne : pages lentes, balises manquantes, contenu dupliqué

✅ Faible priorité : pages peu visitées avec petits bugs ou structure CSS à affiner

💡 Garde une documentation ou un tableau de bord SEO à jour pour suivre les corrections et leur impact dans le temps.

Conclusion

Le SEO technique est bien plus qu’un ensemble de réglages en coulisse : c’est le socle sur lequel repose toute stratégie de référencement durable. Sans des fondations solides, même le meilleur contenu et les backlinks les plus qualitatifs ne suffiront pas à garantir de bons résultats dans les moteurs de recherche.

Optimiser ton site techniquement, c’est :

- Offrir une meilleure expérience aux utilisateurs

- Permettre à Google d’explorer, d’indexer et de classer efficacement tes pages

- Assurer la pérennité de ton référencement face aux évolutions constantes des algorithmes

C’est un travail continu, mais dont les bénéfices à long terme sont incontestables. Plus ton site sera sain, rapide, clair et accessible, plus il pourra rayonner dans les SERP.

FAQ SEO technique

Quelle est la différence entre SEO technique et SEO on-page ?

Le SEO technique se concentre sur la structure, la performance, l’indexabilité et la sécurité du site. Le SEO on-page, quant à lui, concerne le contenu visible par l’utilisateur : textes, balises, maillage interne, expérience de lecture. Ils sont complémentaires.

À quelle fréquence faut-il auditer le SEO technique de son site ?

Un audit complet est recommandé tous les 3 à 6 mois, ou à chaque refonte ou ajout massif de contenu. Des vérifications mensuelles plus légères sont nécessaires pour détecter rapidement les erreurs critiques.

Peut-on avoir un bon SEO sans SEO technique ?

Non. Même avec un excellent contenu et des backlinks de qualité, si ton site est lent, inaccessible, mal structuré ou non indexé correctement, tu seras pénalisé dans les résultats de recherche. Le SEO technique est la condition préalable au succès des autres leviers SEO.

Quel est le meilleur outil pour auditer son SEO technique ?

Cela dépend de ton niveau :

- Débutant : Google Search Console + PageSpeed Insights

- Intermédiaire : Screaming Frog + GTmetrix

- Avancé : Semrush, Ahrefs, OnCrawl + analyse de logs

Le SEO technique est-il réservé aux développeurs ?

Pas du tout ! De nombreux outils simplifient les audits et corrections. Certaines optimisations demandent un minimum de connaissances techniques, mais beaucoup peuvent être appliquées par des webmasters ou marketeurs avec un peu de formation.